파라미터를 잘 설정해야 똑똑한 인공지능을 개발 할 수 있습니다. 이 파라미터를 조정해나가는 과정 을 인공지능의 ‘학습(train)’이라고 하며, 학습하는 데 필요한 데이터는 ‘학습 데이터’라고 합니다.

*본 내용은 셀렉트스타의 '23/24 인공지능 인사이트' 매거진에서 발췌한 것입니다.

1.3 파라미터 조정하기, 인공지능 학습

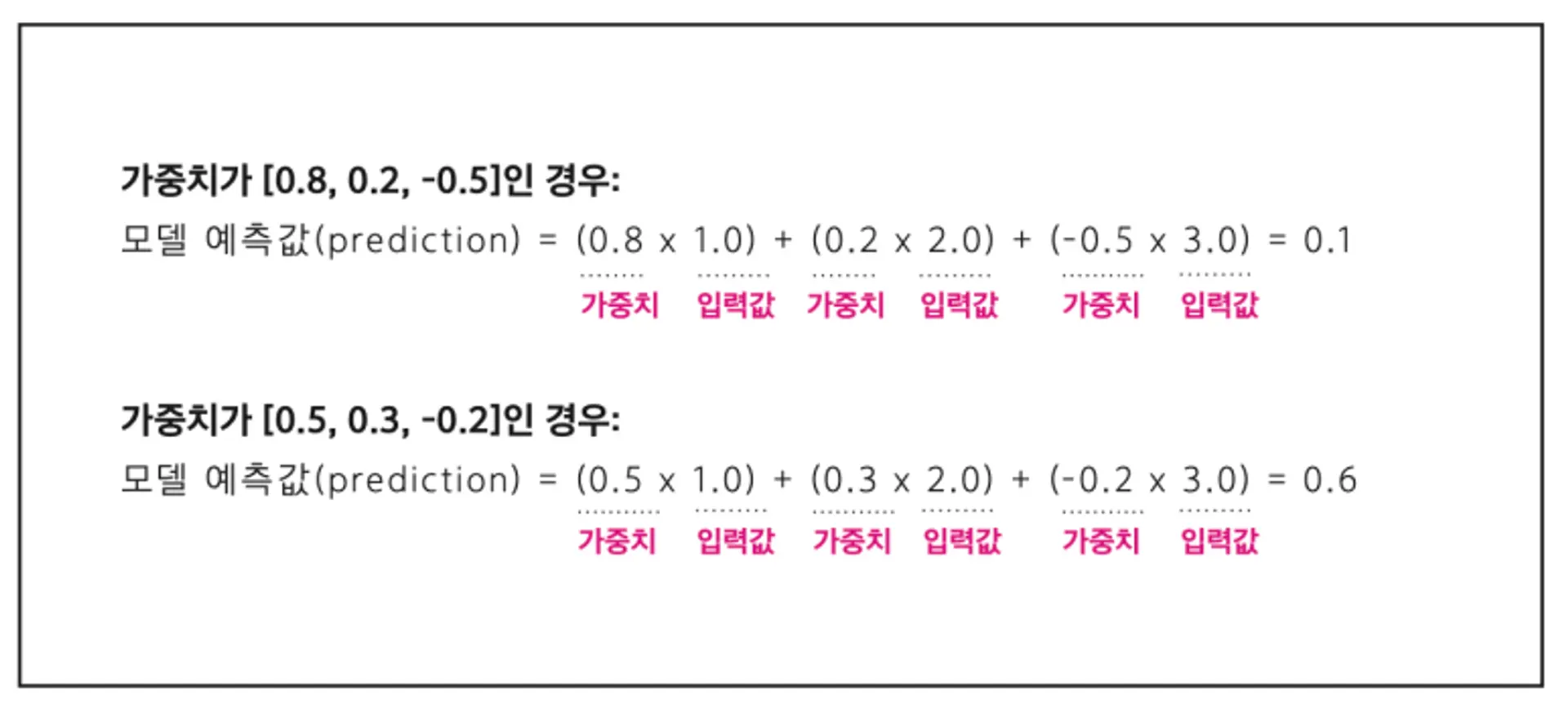

통상 학습 과정에서는 학습 데이터를 활용해 ‘모델의 예측 결과’와 ‘실제 데이터’의 차이를 최소화합니다. 가중치(weight)를 다르게 설정하면 모델의 예측값 (prediction)이 달라지니, 가중치를 조정해가며 점진 적으로 오차를 줄여가는 겁니다.

예를 들어 [1.0, 2.0, 3.0] 세 개의 숫자를 입력값으로 활용해 숫자 하나를 예측하는 문제를 풀고자 합니 다.

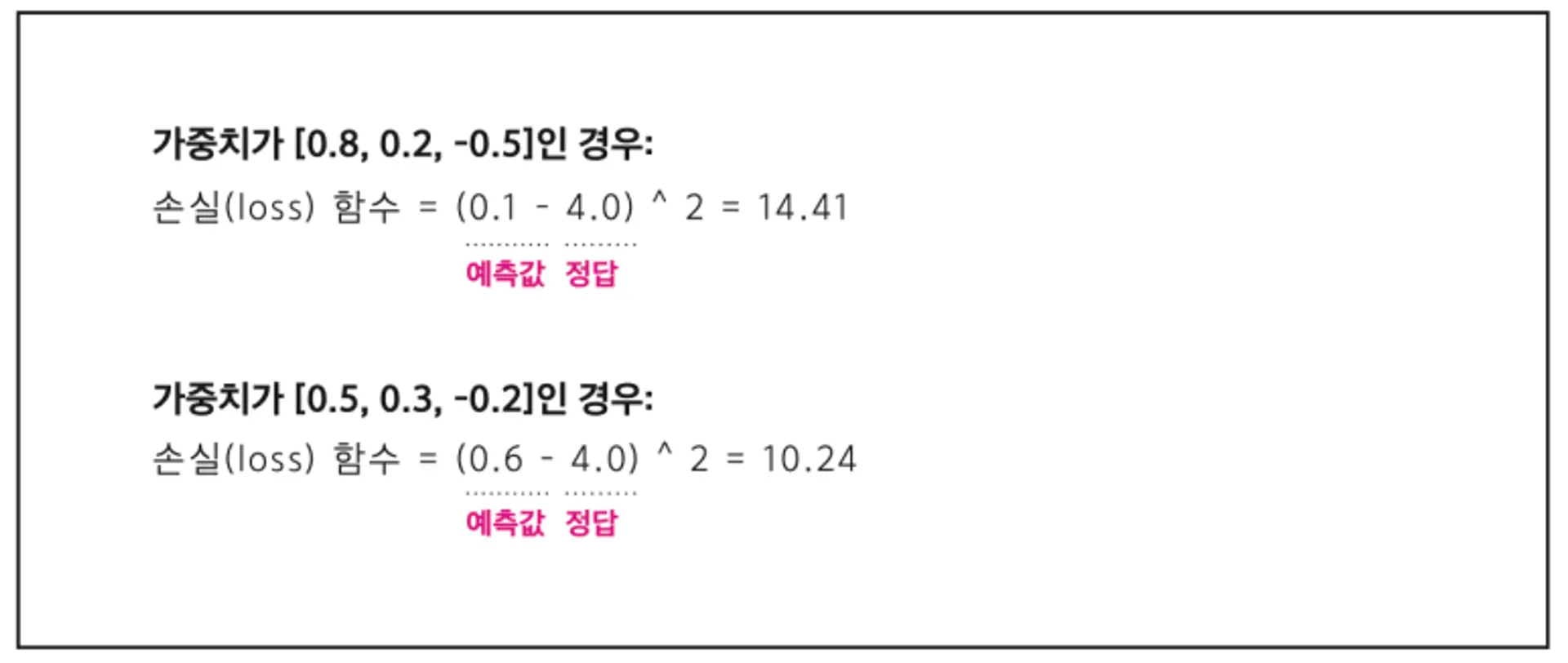

먼저 가중치가 [0.5, 0.3, -0.2]인 경우와 가중치가 [0.8, 0.2, -0.5]인 경우의 모델의 예측값(prediction) 을 계산해보겠습니다. 실제 정답(label)은 4.0이라 가 정하겠습니다.

손실 함수(loss function)를 사용하여 모델의 예측값(prediction)과 실제 정답(label) 간의 차이를 계산합니다. 손실 함수는 인공신경망이 예측한 출력값과 실제 정답의 차이를 계산하여 모델의 성능을 평가하는 함수입 니다. 인공신경망의 목표는 손실함수 값을 최소화하는 최적의 가중치를 찾아내는 것입니다. 손실함수를 예 측하는 회귀 문제에서 일반적으로 사용되는 손실 함수는 평균 제곱 오차(Mean Squared Error, MSE)입니다.

두 식을 비교하면 가중치가 [0.5, 0.3, -0.2]일 때 예 측값과 정답의 차이가 적은 걸 알 수 있습니다. 인 공 지능 학습 과정에선 위 과정을 반복하여 손실 함 수(loss function)를 최소화하는 방향으로 가중치 (weight)와 편향(bias)을 업데이트해 나갑니다.

한데 인공 지능은 학습 과정에서는 가중치 와 편향 등 파라미터를 무작위로 변경하지 않습니 다. 파라미터 조정은 ‘특정한 규칙’에 따라 이뤄집니 다. 모델이 파라미터를 변경하는 규칙을 ‘최적화 알 고리즘’이라고 합니다. 최적화 알고리즘은 다양한 종 류가 있지만, 대표적으로 사용되는 것은 경사 하강 법(gradient descent)입니다.

또한 전체 학습 과정에서 AI 개발자는 학습 한 번에 사용하는 데이터 크기(batch size), 학습 반복 횟수 (epcoch) 등을 자유롭게 설정할 수 있는데 이처럼 데이터 과학자가 학습을 관리하기 위해 활용하는 변 수들을 하이퍼파라미터(Hyperparameters)라고 합니다.

정리해서 말하면 인공 지능은 학습 데이터를 통해 예측값과 실제 정답을 비교하며 파라미터(가중치, 편향 등)를 업데이트합니다. 이때 신경망이 파라미 터를 업데이트하는 특정한 규칙을 ‘최적화 알고리즘’ 이라고 합니다. 최적화 알고리즘을 포함하여, 학습 과정에서 AI 연구자가 설정하는 변수를 통틀어 하이 퍼파라미터(Hyperparameters)라고 합니다.

셀렉트스타는 더욱 스마트한 인공지능을 위한 고품질 학습 데이터를 제공합니다.