한국어 자연어 이해 평가 데이터셋: KLUE

한국어 NLP 대표 벤치마크 데이터셋 8개 종류의 주요 한국어 NLP Task에 대해 국내 주요 연구기관들이 참여한 한국어 NLP 대표 벤치마크 데이터셋 셀렉트스타가 수집하고 가공한 데이터셋을 기반으로 한 KLUE 논문이 세계적인 AI 컨퍼런스 NeurIps(신경정보처리시스템학회/뉴립스) 2021에 채택되었습니다. KLUE는 Korean Language Understanding Evaluation...

눈으로 볼 수 없는 승리의 요소를 찾다: 핏투게더

AI기술이 그려나가는 스포츠의 미래 축구 경기를 이기기 위해서는 어떤 것들이 중요할까요? 아마 가장 중요한 것은 경기를 뛰는 선수들의 실력과 컨디션일 것입니다. 하지만 실력과 컨디션은 눈에 보이는 것이 아니라 정확하게 예측하기가 쉽지 않습니다.핏투게더는 이렇게 눈으로 볼 수 없는 승리의 요소를 찾아내어...

Underdog을 위한 AI 기술 3편: GIST

AI기술은 사회적 약자를 위해 어떻게 발전하고 있을까? Underdog을 위한 인공지능의 발전 세번째 이야기, 의사소통의 장벽을 없애는 기술 GIST의 몸짓 제스처 ‘손담’입니다. 데이터셋 스펙 데이터셋 구축 목적 수어 기반의 중증 장애인 대상의 보완 대책 의사소통 수단인 한국형 몸짓 상징 제스쳐 데이터셋 수량 205개의...

Underdog을 위한 AI 기술 2편: wesee

AI기술은 사회적 약자를 위해 어떻게 발전하고 있을까? Underdog을 위한 인공지능의 발전 첫번째 이야기, 소외된 90%를 위한 기술 WeSee의 교차로 정보 데이터셋입니다. 데이터셋 스펙 데이터셋 구축 목적 저시력자와 같은 교통약자에게 보행신호 및 횡단보도에 대한 정보 전달을 통해 안전 횡단 서비스 제공 수량...

Underdog을 위한 AI 기술 1편: wesee

AI기술은 사회적 약자를 위해 어떻게 발전하고 있을까? Underdog을 위한 인공지능의 발전 첫번째 이야기, 소외된 90%를 위한 기술 WeSee의 교차로 정보 데이터셋입니다. 데이터셋 스펙 데이터셋 구축 목적 저시력자와 같은 교통약자에게 보행신호 및 횡단보도에 대한 정보 전달을 통해 안전 횡단 서비스 제공 수량...

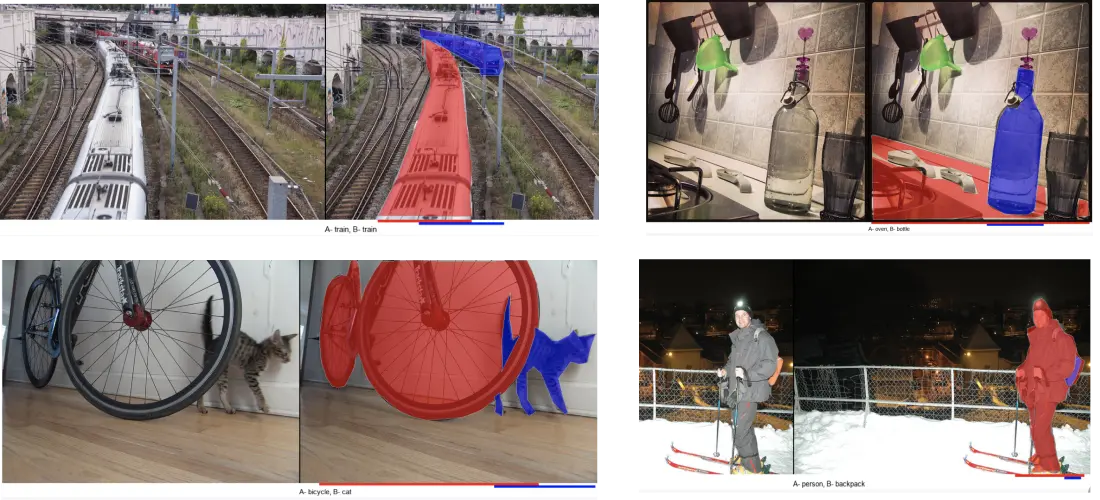

포스텍 ‘InstaOrder 데이터셋’

셀렉트스타의 체계적인 플랫폼 덕분에 양질의 데이터를 빠른 시간내에 수집할 수 있었습니다. 캐시미션 작업 가이드라인은 꼼꼼하게, 실제 예시들을 통해 쉽게 이해할 수 있도록 작성되어 데이터 품질에 큰 도움이 되었습니다. 결과적으로 InstaOrder 데이터셋의 정보를 활용한 네트워크가 기존 픽셀별 거리 예측 네트워크의 성능...